Zatímco servery jedou, my šlapeme do pedálů, visíme na žebřinách a modlíme se Neptunovi.

4 min read

ELOS Sailing Team: Suchá příprava, mokré sny a cesta za další trofejí

By Štěpán Lohnickij on 11.3.2026 19:39:51

21 min read

OpenShift v AWS: bezpečná instalace v Landing Zone

By Jan Burian on 5.3.2026 11:25:31

Instalace Red Hat OpenShift Container Platform (OCP) 4 do AWS účtu v rámci Landing Zone organizace přináší specifická omezení, která je třeba zohlednit již při plánování instalace. Landing Zone účty jsou typicky spravovány centrálně a bývají omezeny z hlediska IAM oprávnění, síťové topologie nebo bezpečnostních politik — například zákazem veřejných S3 bucketů, restrikcí na vytváření VPC či požadavkem na použití krátkodobých credentials místo dlouhodobých IAM klíčů.

Topics: DevOps Kubernetes Red Hat OpenShift Security AWS Landing Zone

4 min read

Co je Istio a proč je klíčové pro provoz microservices na Kubernetes

By Lukáš Smiga on 19.1.2026 11:44:20

Moderní architektura založená na microservices přináší značnou provozní složitost. Jednotlivé služby jsou sice malé a nezávislé, ale ve větším systému jich mohou být desítky až stovky. Každá z nich musí řešit bezpečnost, vyvažování zátěže, monitoring a řízení provozu.

Zatímco u monolitické aplikace stačilo tyto oblasti řešit jednou, v microservices architektuře je nutné je řešit pro každou službu zvlášť. Kubernetes sice poskytuje základní podporu (např. objekt Service, L4 load balancing nebo service discovery), ale neřeší pokročilé scénáře, jako jsou:

- metriky na L7 úrovni,

- inteligentní směrování provozu,

- rate limiting,

- circuit breaking.

Samotný Kubernetes proto nestačí ke spolehlivému provozu většího počtu microservices. Jak systém roste, stává se jeho správa a observabilita stále obtížnější. Zde přichází ke slovu service mesh – dedikovaná infrastruktura, která řeší komunikaci mezi službami transparentně a centrálně, bez nutnosti zásahů do aplikačního kódu.

Topics: DevOps Kubernetes Service Mesh Red Hat OpenShift Microservices

3 min read

Red Hat Podman AI Lab: Bezpečné a efektivní experimentování s AI v kontejnerech

By Lukáš Smiga on 8.12.2025 15:06:22

Vývoj AI aplikací se rychle posouvá z prototypů do reálného nasazení. Firmy hledají způsoby, jak bezpečně experimentovat s modely, integrovat je do svých DevOps procesů a zároveň udržet kontrolu nad daty i náklady. Právě zde vstupuje na scénu Podman AI Lab, novinka, která rozšiřuje funkce populárního container engine Podman o přehledné rozhraní pro práci s AI.

Podman AI Lab přináší možnost jednoduše vytvářet, spravovat a testovat AI řešení přímo lokálně – bez odesílání dat do cloudu a bez nutnosti složitých nástrojů. Pro DevOps týmy a architekty jde o výrazné zjednodušení celého procesu.

Topics: Red Hat OpenShift AI DevOps OpenSource Automation Podman AI Lab

8 min read

SELinux: Noční můra adminů nebo šance na lepší spánek?

By Václav Miller on 10.8.2025 22:10:44

Nedávno jsem byl na schůzce s klientem, kde popisovali svou linuxovou infrastrukturu a mimo jiné zmínili, že na RHEL operačních systémech mají vypnutý SELinux. Protože téma diskuze bylo jiné, tak jsem nepoložil základní otázku: „Proč?”

Topics: Red Hat Enterprise Linux SELinux Security Training

6 min read

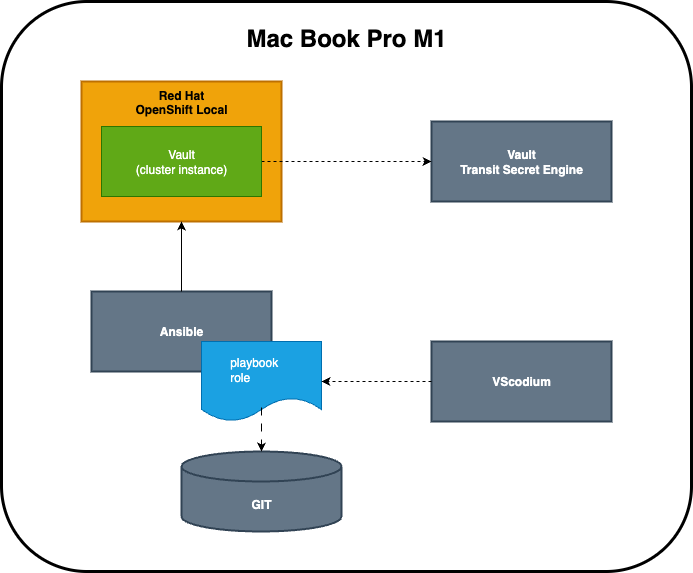

OpenShift Local jako nástroj pro nasazení HashiCorp Vault v praxi

By Václav Miller on 25.7.2025 12:59:45

Pojďme se v článku seznámit s použitím Red Hat OpenShift Local na reálném use-case. Zároveň si odpovíme na otázku, zda jeho použití naplňuje prvky antického dramatu.

Topics: DevOps Kubernetes Ansible OpenShift Local Git Red Hat OpenShift

4 min read

Jujutsu: Moderní alternativa ke Gitu bez (tolika) bolesti

By Lukáš Smiga on 2.7.2025 14:07:37

Git je už dávno standardem pro správu verzí. Ale přiznejme si – kdo z nás si v něm nikdy "neustřelil nohu"? Na první pohled nenápadný překlep, špatně provedený rebase nebo špatně pojmenovaný commit… a je zle. Právě na tyhle chvíle míří nový nástroj z dílny Googlu – Jujutsu (zkráceně jj), který chce verzování zjednodušit, zpřehlednit a zpříjemnit. A to bez přetrhání pout s Gitem.

Topics: DevOps OpenSource Jujutsu rust Git Alternativa

4 min read

Když potřebujete výkon a spolehlivost: Red Hat AI Inference Server v praxi

By Lukáš Smiga on 15.6.2025 22:00:44

Umělá inteligence se stává součástí běžných IT operací. Firemní týmy už dávno neřeší jen to, jak model natrénovat, ale hlavně jak ho stabilně a bezpečně provozovat. A právě tady přichází na scénu Red Hat AI Inference Server – open source nástroj, který umožňuje nasazení AI modelů do produkce ve velkém měřítku, automatizovaně a v souladu s podnikovými standardy.

Topics: Red Hat OpenShift AI DevOps Kubernetes Automation AI Inference MLOps Edge Computing

2 min read

Red Hat Developer Hub: Váš vývojářský portál bez kompromisů

By Vojtěch Veselý on 16.5.2025 8:44:20

Red Hat Developer Hub (RHDH) je moderní portál pro vývojáře, který organizacím umožňuje mít přehled o vývoji, dokumentaci, API i procesech – vše na jednom místě. Je postaven na komunitním projektu Backstage, ale Red Hat jej vylepšuje o funkce, které jsou důležité pro enterprise prostředí: škálovatelnost, bezpečnost, podporu a snadnou integraci do existující infrastruktury.

Topics: DevOps Kubernetes RedHatDeveloperHub Automation BackstageIO

5 min read

Zlepšená správa mikroservisů: OpenShift Service Mesh 3.0 je tady!

By Lukáš Smiga on 6.4.2025 21:36:40

S rozmachem mikroservisní architektury narůstá i potřeba nástrojů, které usnadní jejich správu, sledování a zabezpečení. Red Hat proto uvádí OpenShift Service Mesh 3.0, novou generaci řešení pro správu komunikace mezi službami v rámci OpenShift prostředí. Tato verze přináší výrazný posun směrem k modernímu, flexibilnímu a škálovatelnému přístupu ke správě servisní sítě.